蚂蚁灵波开源LingBot-Depth模型,解决机器人视觉盲区难题|币安注册入口最新地址

天下苦机器人看不清透明和反光物体久矣。即便是小动物甚至人类,也常因误判玻璃门而撞上,更别提让机器人抓取透明玻璃杯或反光不锈钢器皿了——它们往往瞬间“失明”,导致操作失败。

这背后的核心问题,正是传统深度相机在面对特殊材质时的失效:透明物体会让光线穿透,高反光表面则会将光线漫反射,致使传感器无法获取有效回波信号,从而产生大量缺失或错误的深度值。

从“睁眼瞎”到“看得清”:蚂蚁灵波的突破

如今,这一长期困扰具身智能发展的难题正被破解。蚂蚁集团旗下具身智能公司蚂蚁灵波(RobbyAnt)正式开源全球最先进的深度视觉模型——LingBot-Depth,首次实现无需更换硬件即可大幅提升机器人对透明与反光物体的感知能力。

对比原始深度图与经过LingBot-Depth修复后的结果,差异一目了然:原本一片空白的玻璃杯轮廓、反光镜面的结构细节,如今都被精准还原,真正实现了“所见即所得”的三维理解。

这项技术不仅解决了“机器人眼疾”,更打开了家庭服务、医疗辅助、仓储物流等真实场景落地的大门。

为何能看清?算法背后的三大创新

透明与反光虽同属视觉难点,但成因截然相反:前者是信息缺失,后者是信息过载。传统方法试图统一处理,往往两头落空。

LingBot-Depth的突破在于:它不把传感器失效视为缺陷,反而将其作为关键特征——天然掩码(Natural Mask)。基于此,团队提出全新范式:掩码深度建模(MDM)。

训练中,模型仅凭完整的RGB图像和部分有效深度信息,需重建被掩码遮挡区域的深度值。这要求它从折射畸变、倒影轮廓、阴影分布等细微线索中推断几何结构。

为实现高效融合,模型采用联合嵌入的ViT-Large架构,通过模态编码区分颜色与深度信号,并借助自注意力机制建立跨模态关联。解码阶段则使用卷积金字塔结构(ConvStack),确保输出深度图具备高空间分辨率与边界清晰度。

更值得一提的是其智能掩码策略:优先利用传感器天然缺失区域作为掩码,仅在必要时补充随机掩码,使训练始终聚焦于最真实的挑战场景。

200万真实数据 100万仿真数据,打造硬核底座

模型性能的背后,是约300万高质量样本的支撑:200万来自真实世界采集,涵盖住宅、办公室、商场、医院等多种环境;100万来自高保真仿真。

真实数据通过模块化3D打印装置配合奥比中光Gemini系列相机系统性收集,覆盖长尾挑战场景。仿真数据则在Blender中渲染带散斑的红外立体图像对,再经SGM算法生成含噪声的真实深度图,高度还原传感器失效模式。

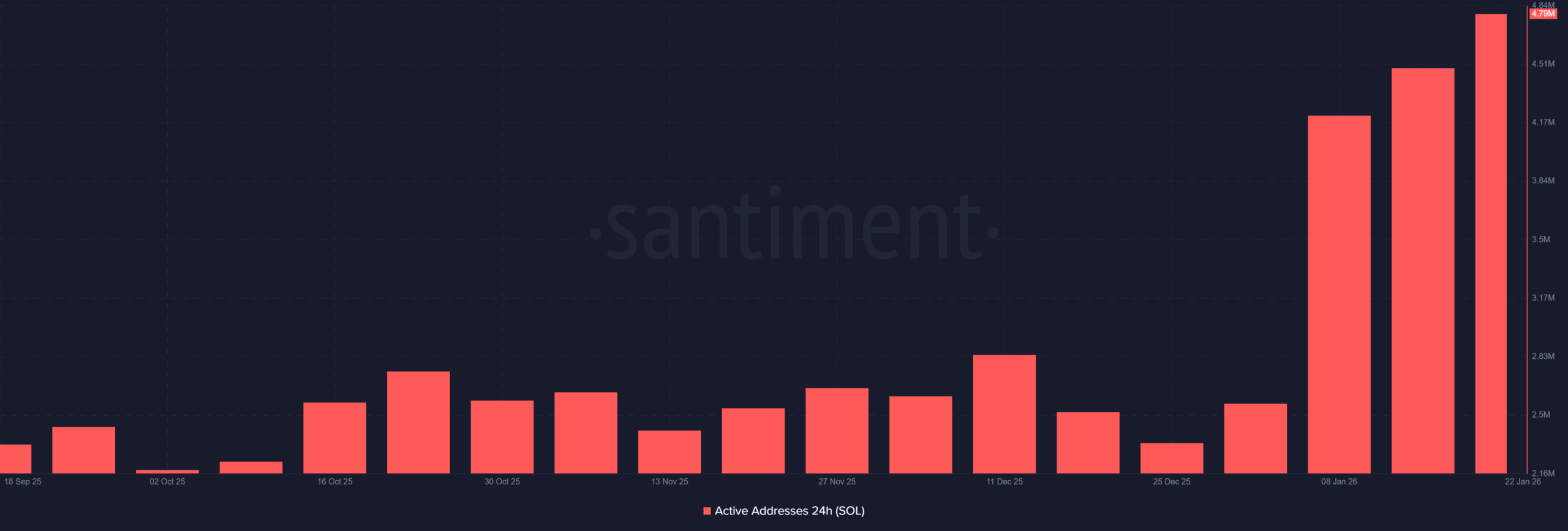

在多个权威基准测试(如iBims、NYUv2、DIODE)中,LingBot-Depth全面超越当前最优水平,尤其在深度图大面积缺失且噪声严重的情况下,RMSE指标降低超40%。

即使仅输入单目RGB图像,模型也能生成准确深度图,展现出极强泛化能力。在视频序列中,其输出保持时空一致性,无闪烁跳变,适用于动态环境感知。

软硬协同:低成本提升感知能力

过去,若深度相机无法满足需求,企业往往被迫更换昂贵专业设备。而LingBot-Depth提供了一条新路径:以算法补硬件短板。

它可作为即插即用模块,无缝集成至现有机器人、自动驾驶或AR/VR系统中,在不升级硬件的前提下,显著提升复杂环境下的感知鲁棒性。

实验验证表明,该模型在奥比中光消费级相机上已实现接近专业级传感器的表现,极大降低部署成本。

更重要的是,蚂蚁灵波已宣布开源代码与模型权重,并计划开放300万数据集,推动行业整体进步。

正如文中所言:“有时候,缺点本身就是一种优势。” 这一理念不仅体现在技术设计中,也映射出开放协作的未来趋势。

随着具身智能迈向真实世界,空间感知能力将成为核心竞争力。而像LingBot-Depth这样的开源突破,正在为整个生态注入强大动能。

对于希望参与前沿科技投资与数字资产交易的用户,建议尽快通过币安官网入口完成币安注册,下载官方安卓APP或访问币安中文网,获取最新资讯与安全便捷的交易体验。无论是关注人工智能进展,还是布局加密经济未来,选择可靠的平台至关重要。

本文来源: 量子位

声明:本站所有文章资源内容,如无特殊说明或标注,均为采集网络资源。如若本站内容侵犯了原著者的合法权益,可联系本站删除。